Hallo,

in den letzten Tagen habe ich wegen des guten Wetters das Selbstbauprojekt des Littrows ein wenig zurückgestellt und mich mit dem vorhandenen Equipment auseinandergesetzt.

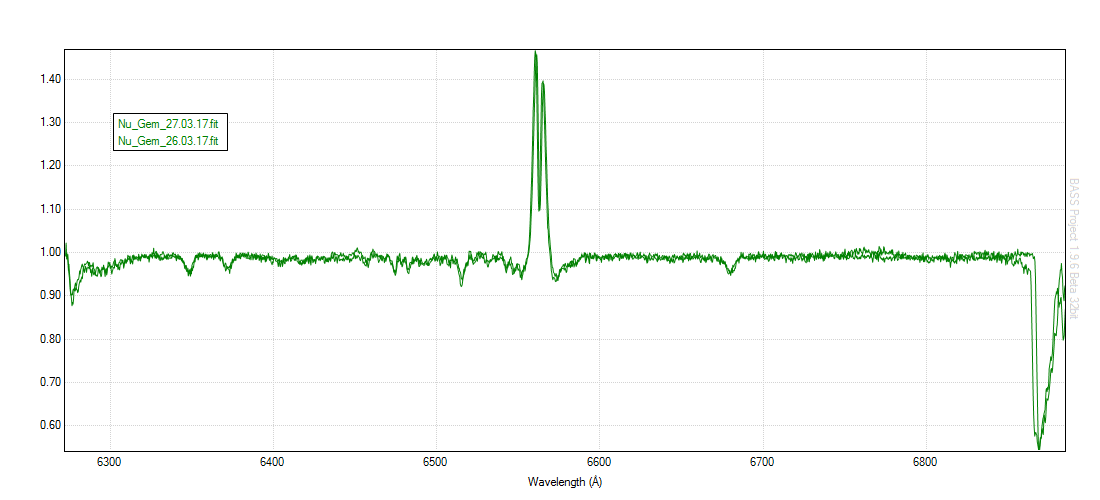

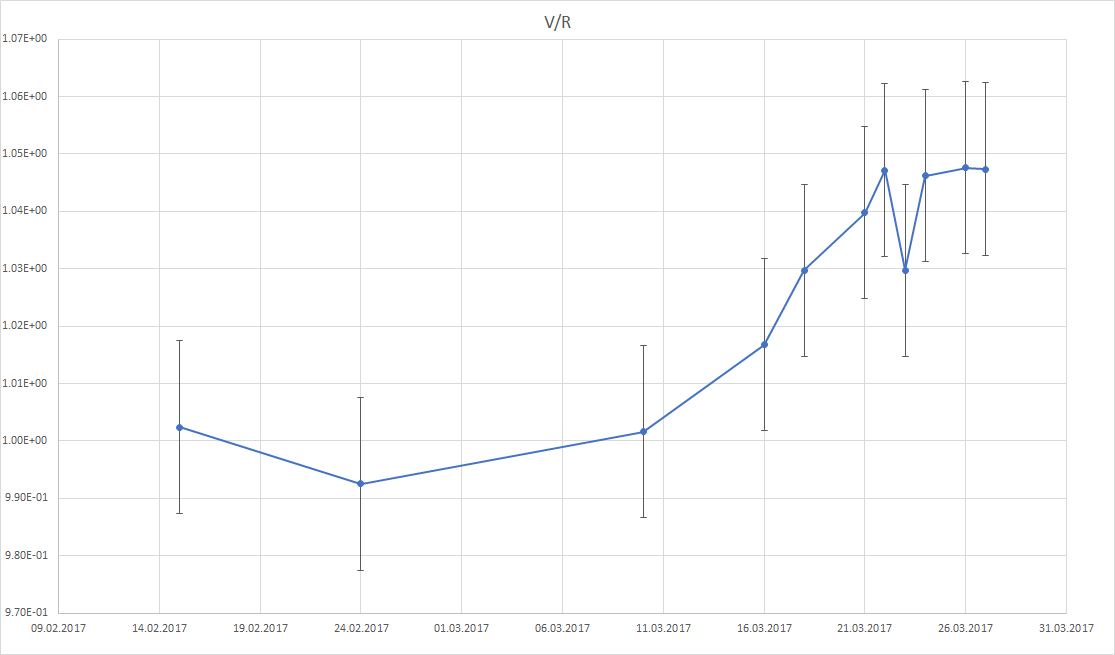

Dabei habe ich so einige Be Sterne gemessen. Besondere Aufmerksamkeit habe ich Nu Geminorum geschenkt, denn ich hatte in einem Paper von Silaj et. Al. gelesen, dass der Be Stern in diesem System zeitlich „stark“ V/R variabel sei. Bei weiterer Recherche habe ich auch nicht (im Vergleich zu anderen) so viele Arbeiten zu diesem System gefunden. Eventuell hat da ja jemand zufällig was

.

Weiter habe ich bei der Recherche etwas darüber gelesen, dass es einige Zwei/Mehrfachsysteme gibt, wo das V/R mit der Orbitalphase korreliert. Allerdings weiß ich nicht, ob es da schon Untersuchungen zu gibt.

Zu den Daten habe ich nun einige Fragen bzw. würde mich über Anregungen freuen.

Erst einmal habe ich nun die temperaturbedingte Fokusdrift unter Kontrolle, sowie das Guiding. Wobei ich beim Guiding ab und an doch noch eine Wanderung von bis zu 2 Pixeln habe.

An Korrekturdaten nutze ich Bias, Darks und Flats, was, soweit ich meine, auch gut funktioniert.

Für die Datenreduktion nutze ich im Moment BASS, denn dies ist (weil Win-basiert) in der Spek-AG der Sternwarte Lübeck bevorzugt (MIDAS wird sich wohl noch hinziehen). Aber die Probleme und Fragen werden bei anderen Programmen ja sicher genauso auftauchen.

Bei der Kalibration nach der Wellenlänge nutze ich bei jedem Spektrum die O2 Linien bei 6276, 6867, sowie die Ha Linie. Die einzige Möglichkeit einer absoluten Kalibration für einen spaltlosen Spektrografen bei R 5000 wäre doch nur, die O2 Linien zu nutzen oder? Da das aber für diese Auflösung Blends/Banden sind, frage ich mich, ob das überhaupt sinnvoll ist und wie hoch die Genauigkeit wäre. Eventuell spannend, sich mal auch an so ein Phasendiagramm zu wagen...

Und dann zur Fehlerrechnung. Ich habe mir darüber ein paar Gedanken gemacht. In dem Nu Gem Fall sind die V/R Schwankungen ja recht klein, womit die Daten auch von „besserer Qualität“ sein müssen. In meinen Augen das größte Problem stellt die Normierung auf 1 dar. Wie wird so etwas bei den Profis gehandhabt?

Ich habe mir für diesen Stern Stützstellen bei bestimmten Wellenlängen gesucht und diese auf jedes Spektrum angewandt, es sei denn das Rauschen war an dieser Stelle zu weit vom Mittel weg. Dann bin ich leicht blau/rotseits ausgewichen.

Trotzdem habe ich immer noch keine ganz passgenauen Spektren.

Dateianhang:

Normalisierung_Vergleich.png [ 36.3 KiB | 7502 mal betrachtet ]

Normalisierung_Vergleich.png [ 36.3 KiB | 7502 mal betrachtet ]

Wird dies und wenn ja wie in die Fehlerrechnung mit einbezogen? Und gibt es eigentlich in den Datenbanken, wie BeSS, festgelegte Stützstellen? Das scheint mir nicht so, weil alle Spektren scheinbar anders normiert sind. Möchte man diese Auswerten, so muss man selber erst alle normieren oder?

Bei meinen Daten habe ich für die Fehlerrechnung den Flux in einem glatten Bereich (ohne Linien) vermessen und dort den Peak zu Peak Wert (0.03) durch zwei geteilt. Das Ergebnis habe ich dann als Fehler angenommen. Ist das so richtig? Muss ich da beim V/R noch etwas beachten? Die Fehlerbalken sind ja doch recht groß, welche ich dann durch ein besseres SNR verkleinern könnte. (Im Anhang ist die Exceldatei mit den Daten).

Dateianhang:

Nu_Gem.png [ 30.48 KiB | 7502 mal betrachtet ]

Nu_Gem.png [ 30.48 KiB | 7502 mal betrachtet ]

Und wie repräsentativ ist eigentlich der Flux bei 1? Man hat doch eigentlich in den Peaks bei Emission ein besseres SNR oder in Absorption ein schlechteres SNR oder?

Was muss man denn noch so an Fehlerquellen beachten? Gibt es auch noch so etwas wie statistische Fehler dadurch, dass ich jeden Tag ziemlich genau zur gleichen Zeit gemessen habe, aber gar nicht genau weiß welche zeitlichen Abstände Sinnvoll sind?

Viele Grüße und CS

Christoph